Apple chi 2 tỷ USD mua Q.ai, đặt nền móng cho AI “im lặng”

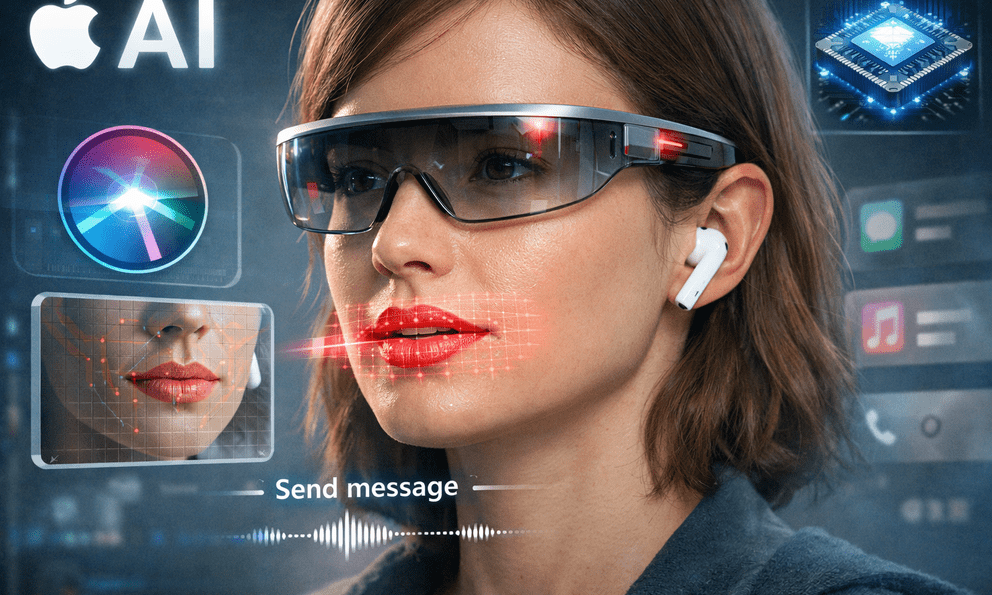

Q.ai phát triển các hệ thống học máy có khả năng phân tích vi chuyển động trên da mặt, chuyển động môi và hoạt động cơ rất nhỏ. Công nghệ này có thể nhận diện các từ được mấp máy môi mà không phát ra âm thanh, biểu cảm cảm xúc và thậm chí một số chỉ số sinh lý như nhịp tim hay nhịp thở.

Nhà phân tích Ming Chi Kuo trước đó dự đoán AirPods tích hợp camera có thể ra mắt trong năm 2026, sử dụng cảm biến hồng ngoại tương tự hệ thống lập bản đồ chiều sâu của Face ID. Khi kết hợp với thuật toán của Q.ai, phần cứng này có thể cho phép người dùng gửi tin nhắn, kích hoạt Siri hoặc điều khiển nhạc chỉ bằng khẩu hình miệng.

Công nghệ này có thể mở rộng sang các thiết bị khác như Apple Vision Pro và các mẫu kính thông minh trong tương lai. Nhà sáng lập Q.ai là Aviad Maizels, từng đồng sáng lập PrimeSense. Công nghệ cảm biến 3D của PrimeSense sau đó được phát triển thành nền tảng cho Face ID trên iPhone.

Từ điều khiển bằng giọng nói sang tương tác bằng cảm biến

Nếu được triển khai, cơ chế nhập liệu bằng chuyển động khuôn mặt có thể đánh dấu bước chuyển từ lệnh giọng nói sang tương tác kín đáo dựa trên cảm biến. Người dùng có thể giao tiếp với thiết bị đeo mà không cần nói “Hey Siri” hay phát âm thành tiếng.

Tuy nhiên, việc theo dõi liên tục chuyển động môi và cơ mặt đặt ra nhiều vấn đề về quyền riêng tư. Dữ liệu sinh trắc học thu thập được có thể tiết lộ trạng thái cảm xúc, chỉ số sức khỏe hoặc nội dung giao tiếp riêng tư nếu bị lưu trữ và xử lý không phù hợp. Ngoài ra còn có lo ngại về khả năng bị theo dõi trái phép hoặc phân tích ý định từ xa.

Nếu Apple triển khai rộng rãi công nghệ này, cách con người tương tác với máy tính có thể thay đổi đáng kể. Đồng thời, tranh luận về mức độ dữ liệu mà thiết bị đeo được phép quan sát cũng sẽ trở nên gay gắt hơn.

Phạm Hoàng